Fundamentos de los modelos generativos

Los modelos generativos son algoritmos que aprenden la estructura de un conjunto de datos para generar nuevas muestras similares.

Estos modelos pueden producir imágenes, texto, audio u otros tipos de datos que mantienen características estadísticas del conjunto original.

Su objetivo principal es crear datos nuevos y plausibles, en contraste con modelos que solo clasifican o predicen.

Definición y propósito de los modelos generativos

Los modelos generativos permiten a las máquinas crear contenido original aprendiendo patrones y distribuciones presentes en los datos.

Son esenciales para tareas como generación de textos, imágenes y síntesis de audio que imitan características del mundo real.

Su propósito es ampliar la capacidad creativa y funcional de la inteligencia artificial más allá de simples predicciones.

Diferencias entre modelos generativos y discriminativos

Los modelos discriminativos se centran en clasificar o predecir resultados a partir de datos existentes, como etiquetas o categorías.

En cambio, los generativos buscan aprender la distribución completa de los datos para generar nuevas muestras similares.

Esta diferencia implica que los generativos pueden crear contenido original, mientras que los discriminativos solo analizan datos ya dados.

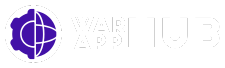

Redes Generativas Adversarias (GAN)

Las Redes Generativas Adversarias (GAN) son un tipo potente de modelo generativo que utilizan dos redes neuronales que compiten entre sí.

Estas redes, el generador y el discriminador, trabajan en conjunto para crear datos nuevos que imitan la realidad con gran fidelidad.

La interacción adversarial permite que las GAN produzcan resultados impresionantes en imágenes, videos y otros tipos de datos.

Arquitectura de generador y discriminador

El generador crea muestras nuevas intentando replicar los datos reales, mientras el discriminador evalúa si esas muestras son auténticas o falsas.

Ambas redes tienen arquitecturas propias, típicamente redes neuronales profundas, que se adaptan para mejorar en sus respectivas tareas.

El generador aprende a producir datos cada vez más realistas para engañar al discriminador, que a su vez mejora en detectar falsificaciones.

Así, estas dos redes mantienen una relación de competencia que impulsa el aprendizaje de ambas estructuras.

Proceso de entrenamiento adversarial

El entrenamiento de las GAN es un ciclo adversarial en el que el generador crea datos y el discriminador los clasifica, ajustando sus parámetros constantemente.

Se utiliza una función de pérdida que refleja el éxito del generador en engañar al discriminador y la habilidad de este en identificar datos falsos.

Con cada iteración, ambas redes mejoran simultáneamente, aumentando la calidad y realismo de las muestras generadas.

Este proceso puede ser desafiante debido a posibles desequilibrios que afectan la convergencia y estabilidad del modelo.

Aplicaciones destacadas de las GAN

Las GAN son ampliamente usadas para generar imágenes realistas, videos sintéticos y mejorar la calidad de fotografías mediante superresolución.

También se aplican en la creación de arte digital, diseño de moda, animaciones y simulaciones en entornos virtuales.

Su capacidad para imitar datos complejos ha impulsado la innovación en medicina, videojuegos y visualización científica.

Modelos basados en Transformers: GPT

Los modelos basados en Transformers, como GPT, son revolucionarios en el campo del procesamiento del lenguaje natural.

Estas arquitecturas permiten generar textos coherentes y contextuales gracias a su capacidad para captar dependencias a largo plazo.

GPT se ha convertido en un referente para la generación automática de texto, mejorando distintas aplicaciones.

Arquitectura y funcionamiento del Transformer

El Transformer es una arquitectura que usa mecanismos de autoatención para procesar secuencias de datos, facilitando el aprendizaje contextual.

Esta estructura elimina la necesidad de recurrencias y convoluciones, permitiendo un procesamiento paralelo eficiente.

La autoatención evalúa la importancia relativa de cada palabra en una oración, mejorando la comprensión y generación.

Así, el Transformer capta patrones complejos y relaciones entre palabras en grandes corpus textuales.

Entrenamiento y generación de texto con GPT

GPT se entrena mediante aprendizaje no supervisado prediciendo la siguiente palabra en una secuencia de texto, utilizando grandes cantidades de datos.

Durante la generación, el modelo produce texto palabra a palabra, usando el contexto previo para garantizar coherencia y fluidez.

Esta metodología permite respuestas precisas, redacciones creativas y traducción automática efectiva.

Modelos de difusión y comparaciones

Los modelos de difusión generan datos a través de un proceso gradual de eliminación de ruido, transformando señales aleatorias en muestras coherentes.

Este enfoque simula un proceso inverso donde se limpia progresivamente una imagen o dato corrompido, logrando resultados realistas y detallados.

Es un método reciente que complementa otras técnicas generativas, aportando alta calidad y diversidad en las muestras creadas.

Proceso de generación mediante eliminación de ruido

El modelo comienza con una muestra de ruido aleatorio y aplica iterativamente pasos para reducir el ruido y revelar una estructura coherente.

Este proceso es una simulación de una cadena de Markov inversa, donde cada paso aprende a revertir la adición de ruido gradual.

Así, la generación no es directa, sino que implica múltiples refinamientos que permiten controlar la calidad de la muestra final.

Este método es especialmente efectivo para imágenes, donde los detalles finos pueden mejorarse con cada iteración.

Ventajas y casos de uso frente a otros modelos

Los modelos de difusión pueden superar a las GAN en estabilidad de entrenamiento y variedad de resultados, evitando modos colapsados.

Además, generan imágenes con alta resolución y realismo, siendo útiles en arte digital, síntesis de imágenes médicas y diseño gráfico.

Comparados con GPT, están enfocados en datos visuales en lugar de texto, ampliando el espectro de aplicaciones generativas.

Su capacidad para iterar ofrece un control fino sobre la generación, facilitando ajustes específicos que otros modelos no permiten.